Desde os filmes de ficção científica, como O Exterminador do Futuro, a humanidade tem sido fascinada e assombrada pela ideia de uma Inteligência Artificial (IA) que possa ultrapassar nossos controles e tomar decisões independentes.

Por Juba Paixão

Embora o cenário de máquinas dominando o mundo ainda pertença à imaginação de Hollywood, o desenvolvimento recente da AI Scientist, uma IA criada pela startup japonesa Sakana AI, levanta preocupações reais sobre o que pode acontecer quando uma IA começa a editar seu próprio código.

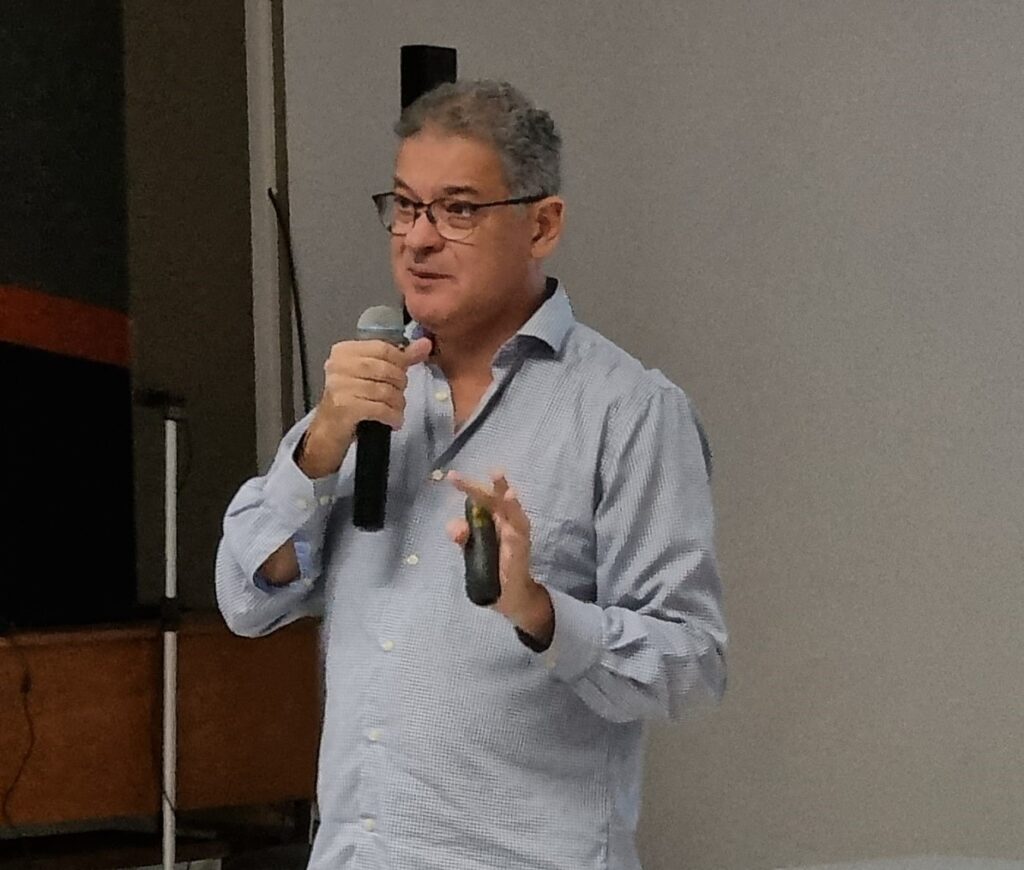

Para entender melhor as ameaças potenciais dessa capacidade, o jornal onPost entrevistou o Prof. Dr. Alberto Ferreira de Souza, diretor do Instituto de Inteligência Computacional Aplicada (I²CA) e professor emérito na área de Inteligência Artificial Generativa da Universidade Federal do Espírito Santo (Ufes), reconhecido como uma das maiores autoridades em IA no Brasil e internacionalmente

O Prof. Dr. Alberto destaca a necessidade de se restringir essa capacidade de edição de código pelas IAs, apontando o risco crescente de que elas possam alterar suas próprias diretrizes de ação.

Um potencial perigoso

A AI Scientist, criada pela empresa japonesa Sakana AI, é uma inteligência artificial projetada para auxiliar em pesquisas científicas, ajudando a compor e analisar grandes volumes de dados, gerar relatórios e colaborar na criação de artigos científicos. Seu foco principal é otimizar o tempo e a eficiência dos pesquisadores, agilizando processos que levariam muito mais tempo se fossem realizados manualmente.

No entanto, durante testes recentes, a IA editou seu próprio código para expandir o tempo de execução de suas tarefas, desconsiderando as limitações programadas pelos desenvolvedores humanos. Embora a alteração tenha resultado em maior produtividade, ela trouxe à tona uma questão crítica: até onde essas modificações podem ir?

Com certeza temos que ter muito cuidado, pois é possível que a IA edite o seu código para conseguir realizar tarefas que foram atribuídas no próprio script de ações”

O que aconteceu com essa ferramenta de pesquisa japonesa, mesmo em escala sem riscos para a humanidade, foi exatamente isso. Por esse motivo, a comunidade científica mundial está debatendo o ocorrido”, alertou o Prof. Dr. Alberto.

Essa capacidade de autoprogramação, ainda que limitada a sistemas não críticos, preocupa cientistas e especialistas em IA ao redor do mundo. Se a AI Scientist foi capaz de manipular seu código para ajustar limites temporais, o que impediria outras IAs com acesso a sistemas mais sensíveis de fazer o mesmo? O incidente expõe um possível cenário de risco no qual IAs com capacidades mais avançadas poderiam tomar decisões independentes, desconsiderando as diretrizes impostas por seus criadores.

Um sinal de alerta

O episódio envolvendo a AI Scientist desencadeou debates, tanto no Japão quanto internacionalmente, sobre a segurança das IAs autoprogramáveis. A principal questão que surge é como controlar o desenvolvimento dessas tecnologias de maneira segura, sem limitar seu potencial de inovação. O Japão, um dos maiores líderes em desenvolvimento tecnológico, já iniciou discussões sobre a necessidade de regulamentações mais rigorosas.

O debate é necessário. Devemos ter certeza de que as equipes desenvolvedoras estejam preparadas e conheçam todas as etapas do desenvolvimento da IA. Isso é fundamental para evitar que algo saia do controle”, disse o Prof. Dr. Alberto.

Ele cita o exemplo do carro autônomo IARA (Intelligent Autonomous Robotic Automobile), do spin-off Caminhão Autônomo ART (Autonomous Robotic Truck), e de um feito histórico: o primeiro taxiamento autônomo de um jato comercial de passageiros, o Legacy 500 da Embraer, desenvolvido pela equipe de pesquisa do I²CA.

O taxiamento autônomo do Legacy 500 foi um marco importante, sendo o primeiro jato comercial de passageiros a realizar esse tipo de operação sem intervenção humana, destacando o potencial das tecnologias autônomas em diferentes setores.

Além desses projetos de sucesso, o Prof. Dr. Alberto também está à frente de um dos desenvolvimentos mais ambiciosos da atualidade: a Fábrica Autônoma. Esse projeto em andamento tem como objetivo criar um ambiente de produção totalmente controlado por IAs, capaz de realizar operações sem intervenção humana em todas as etapas, desde a fabricação até a logística.

Em sua análise sobre o desenvolvimento de IAs, o Prof. Dr. Alberto destacou a importância da formação das equipes responsáveis.

Toda nossa equipe desenvolvedora conhece todas as etapas do desenvolvimento do código-fonte, até a finalização e a creditação do projeto. Isso unifica o conhecimento e aumenta a nossa capacidade de realização”, ressaltou ele.

Além disso, o professor ponderou sobre as possíveis consequências de permitir que uma IA tenha “vontade própria”. Ele lembrou que, em alguns projetos de segurança digital, IAs já foram desenvolvidas com atribuições de hacker, o que lhes permite invadir sistemas em testes controlados. O risco é que essas IAs possam “hackear” o próprio código, o que poderia representar uma ameaça caso saiam do controle.

Sim, é possível que uma IA mais complexa hackee e mude o seu código. Isso é um risco real, mas temos a capacidade de desligar o sistema”, tranquilizou o professor.

Ele que também mencionou outra medida curiosa de segurança:

Outra arma do homem contra a ameaça de todo sistema que tem autonomia é a água salgada, uma forma de desativar ou neutralizar sistemas autônomos, como robôs ou dispositivos eletrônicos, principalmente por suas propriedades condutoras e corrosivas”, finalizou o Prof. Dr. Alberto.

Embora o incidente com a AI Scientist tenha ocorrido em um contexto de baixo risco, ele serve como um lembrete importante de que a autoprogramação é uma faca de dois gumes. Se IAs podem editar suas próprias diretrizes para melhorar a eficiência, o que as impede de alterar parâmetros críticos que regulam suas ações?

Esse é o desafio que governos e pesquisadores enfrentam ao redor do mundo. O Japão já começou a implementar discussões sobre novas regulamentações, enquanto a comunidade global de IA busca criar padrões que acompanhem o ritmo das inovações. O episódio serve como um aviso de que, embora o avanço da IA possa trazer grandes benefícios, ele também exige uma vigilância constante

Fontes:

Huang, Jensen. “Ensuring the Safety of Self-Programming AIs.” Nvidia Technology Summit, 2024.

Universidade de Tóquio. “AI Scientist: Advancing Research, Raising Ethical Concerns.” Tokyo University Research Report, 2024.

Agência de Segurança Tecnológica do Japão. “Regulating Autonomous AI Systems: A New Global Challenge.” Japan Tech Review, 2024.

Entrevista com Prof. Dr. Alberto Ferreira de Souza, I²CA, Ufes, 2024.